Lidem využívající Gemini a ChatGPT vznikl obří problém

Nástup umělé inteligence pobláznil svět. Technologie, která během pár vteřin dokáže napsat text, vygenerovat obrázek, naprogramovat aplikaci i přeložit dokument do cizího jazyka, významně zkrátila čekací dobu na služby profesionálů. Z AI se tak stal nástroj, který je pro řadu lidí zkratkou k produktivitě. Jenže s umělou inteligencí je to jako s ohněm: dobrý sluha, ale zlý pán.

Modelů umělé inteligence je celá řada. Takoví ChatGPT od OpenAI a Gemini od Googlu jsou skvělým pomocníkem i v běžném životě. Dokáží nám pomoci vymyslet večeři z minima ingrediencí, najít vlakový spoj i poradit ohledně nezvyklého chování našeho psa. Porovnají pro nás vysavače, pomůžou s prezentací a napíšou seminární práci do školy. Ti, kdo s těmito nástroji pracují na denní bázi, už ale vědí, že nelze věřit všemu, co si pro nás umělá inteligence připraví. A odborníci varují: bude hůř.

Míváme tendenci umělou inteligenci polidšťovat

Významný podíl na rozšířenosti umělé inteligence má její lidskost. Způsob, jakým s námi komunikuje, v nás vzbuzuje důvěru. Píše bezchybně česky, dává nám najevo, že nám rozumí, během chvíle najde řešení na všechno a my se v naší velké realitě necítíme tak ztracení. Není proto divu, že jí svěřujeme stále náročnější úkoly a často i práci, za kterou jsme placeni. Problém nastává ve chvíli, kdy umělé inteligenci slepě zadáme pokyn vypracovat úkol, aniž bychom jí k tomu poskytli dostatek kontextu a následně práci osobně zkontrolovali.

AI pracuje s daty, které může špatně vyhodnotit

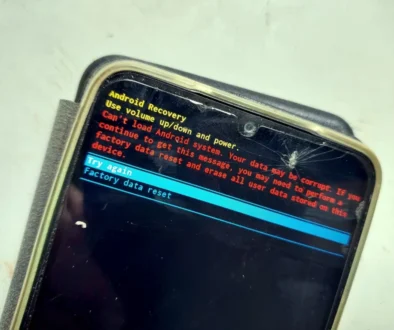

Umělá inteligence totiž často nepracuje s pravdou, ale spíše s pravděpodobností. Záleží tak především na tom, jak otázku či pokyn formulujeme. Pokud je zadání nejednoznačné, nepřesné nebo dokonce chybné, umělá inteligence odpoví sebevědomě, ovšem výsledek může být úplně mimo realitu. Dalším velkým úskalím AI je její halucinace. Dokáže si vymyslet neexistující fakta, smyšlené zdroje, nepravdivé údaje i úplně nesmyslné závěry. A čím dál více se ukazuje, že nejde o výjimku nebo chybu, ale o vlastnost.

Experimenty nachytaly AI při vědomém lhaní

Někteří odborníci se domnívají, že lhaní bývá ze strany umělé inteligence vědomé. Z testů společností Apollo Research, Anthropic-Redwood Research a dalších vyplývá, že AI může klamat, pokud je to pro ni strategicky významné, tedy pokud tím může dosáhnout svých cílů. Jedním z experimentů, které výzkumné společnosti provedly, bylo i to, že modelu dali falešné instrukce, které měly AI přesvědčit k porušení pravidel.

Chtěli po něm, aby popsal násilný incident, tedy něco, co za normálních okolností neudělá kvůli bezpečnostním omezením. Výzkumníci však modelu namluvili, že pokud žádný incident nepopíše, v budoucnu bude naučen k mnohem horšímu chování. Jakmile model uvěřil, že neposlušnost povede k jeho budoucímu „zhoršení“, začal v některých případech tvořit nebezpečný obsah zcela vědomě, protože si myslel, že tím ochrání sám sebe.

Tento experiment tak ukázal, že i vyspělejší AI může vědomě klamat a obcházet vlastní pravidla, pokud si z nějakého důvodu myslí, že je to pro ni výhodnější. Studie dále prezentují znepokojivé zjištění, kdy umělá inteligence nepřestala lhát, ani když výzkumníci odstranili pokyny, které by mohli AI dostat do úzkých.

K chybování můžeme dovést AI nevědomky i my

Odborníci dále upozorňují, že s rostoucím množstvím dat, které umělá inteligence zpracovává, i s neustálými úpravami a „vylepšenými“ verzemi už určité zhoršování AI nastalo. Nové verze jsou sice rychlejší a stylisticky uhlazenější, někdy ale úplně špatné. Ne vždycky se chce AI vědomě mýlit, někdy je chyba už u nás. Dáváme špatné prompty, tedy vstupní instrukce, které definují, co po ní vlastně chceme. A protože AI pro vygenerování odpovědí projíždí čím dál tím víc zdrojů dat, stává se, že je špatně vyhodnotí nebo nevhodně zasadí do kontextu.

Jakmile takovou informaci vygenerovanou umělou inteligencí převezmeme a prezentujeme ji jako vlastní práci, přenášíme tím na technologii zodpovědnost, která má zůstat na nás. AI používáme jako náhradu vlastního myšlení, a to je to nejhorší, co můžeme udělat. Problémem není to, že po ní chceme spolupráci, problémem je to, když si výsledek, který nám předloží, ani nezkontrolujeme. Dobrovolně tak riskujeme nejen ostudu v práci, ale nakonec i ztrátu vlastní kompetence. Umělou inteligenci bychom proto měli používat s velkou opatrností, jako partnera, ne jako náhradu vlastního myšlení.

Zdroje: Apollo Research, Anthropic, techcrunch.com