Čtyřnozí roboti již dokáží překonávat nerovnosti. Tohle je revoluce

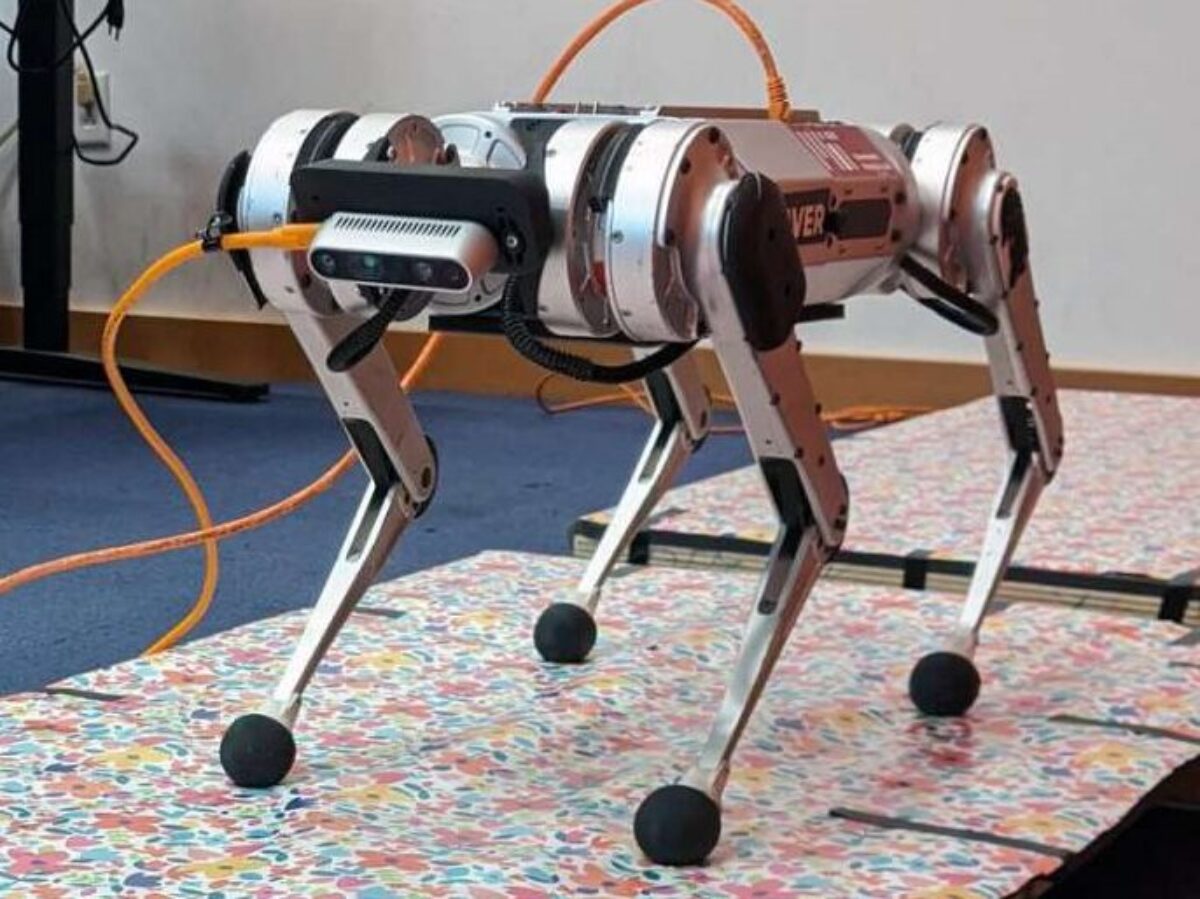

Nový řídicí systém robota MIT mini gepard umožňuje skákat přes nerovný terén v reálném čase. Jedná se o obrovský pokrok ve vývoji autonomních robotů, píše portál techxplore.com.

Až dosud se čtyřnozí roboti volně pohybovali po rovném terénu, ale když narazili na překážky v podobě hrbolů, tak to nezvládli. Díky novému systému mohou chodit i po nerovném terénu bez obav z převrácení.

Zvířata i lidé používají oči k tomu, aby se vyhnuli překážkám. Je těžké nespadnout do díry, když ji nevidíte. Robotičtí gepardi je neviděli, takže běh po nerovném terénu pro ně byl velmi obtížný.

Gabriel Margolis, postdoktorand v laboratoři Pulkita Agrawala a profesor informatiky v Laboratoři počítačové vědy pro umělou inteligenci (CSAIL) na proslulém Massachusettském technologickém institutu (MIT), a jeho kolegové vyvinuli systém, který zvyšuje rychlost a obratnost nohatých robotů tím, že jim umožňuje snadno přeskakovat mezery a díry v zemi.

Nový řídicí systém je rozdělen na dvě části – jedna zpracovává vstupní informace v reálném čase z videokamery umístěné na přední straně robota a druhá převádí tyto informace na pokyny, jak má robot pohybovat svým tělem. Výzkumníci testovali svůj systém na výkonném hbitém robotu Minigepard, který byl sestrojen v laboratoři Sangbae Kima, profesora strojního inženýrství na MIT.

Na rozdíl od jiných metod ovládání čtyřnohého robota tento dvoudílný systém nevyžaduje předchozí mapování terénu, takže robot se může pohybovat na libovolném místě. V budoucnu by tak roboti mohli vyrazit do lesa na záchrannou misi nebo stoupat po schodech, aby například doručili léky starším lidem do jejich domovů.

Kamera robota snímá hloubkové obrazy přibližujícího se terénu, které jsou přenášeny do řídicí jednotky vyšší úrovně spolu s informacemi o stavu těla robota (úhly kloubů, orientace těla). Vysokoúrovňový regulátor je neuronová síť, která se „učí“ na základě zkušeností. Trénování neuronové sítě probíhalo metodou pokusů a omylů, známou jako posilovací učení. Byly provedeny simulace, při nichž robot projížděl stovkami různých nepravidelných terénů a za úspěšné pokusy byl odměněn. Algoritmus se tak naučil, jaké akce má provádět, aby získal co největší odměnu.

Zdroj: techexplore.com