Nová zbraň kyberzločinců. Mohou mluvit klonovaným hlasem

Technologie klonování hlasu je stále dokonalejší. Účinnost kopírování a napodobování zvuků vycházejících z úst konkrétního člověka pomocí umělé inteligence je natolik působivá, že přitahuje zájem technologických hráčů, ale i kybernetických zločinců – upozorňuje BBC.

Klonování hlasu není nic jiného než syntetická kopie hlasu vytvořená počítačovým programem. Umělá inteligence dokáže z nahrávky mluvícího člověka vytvořit jeho hlas, který však říká libovolná slova nebo věty. Vynález závisí na tom, co uživatel takového softwaru napíše na klávesnici počítače. Zvuk je tak přesný, že podle BBC byl známý dabér a herec Tim Heller, který namlouvá animované filmy, audioknihy a videohry, ohromen, když slyšel umělou inteligenci mluvit svým hlasem.

Umělá inteligence při poslechu hlasových vzorků vybrané osoby (stačí 10minutová nahrávka) dokáže rozpoznat nejen přízvuk, barvu a tón hlasu, ale také tempo, plynulost mluvených vět, a dokonce i charakteristické pauzy na oddech. Falešný hlas nejenže dokáže vyslovit jakékoli téma, ale umělá inteligence je schopna tímto způsobem prezentovat jakoukoli požadovanou emoci – od hněvu přes štěstí nebo nudu až po strach.

Herci chtějí tento software používat i v budoucnu. Heller již oznámil, že díky umělé inteligenci by mohl přijímat další zakázky a posílat do práce jen svůj syntetický hlas. Jak uvádí BBC, herec se již rozhodl naklonovat svůj hlas, za tímto účelem se obrátil na společnost VocaliD, bostonský startup založený profesorem Rupalem Patelem z Northeastern University (dříve vedl klinickou práci na vytvoření umělého hlasu pro pacienty, kteří ztratili schopnost mluvit v důsledku operace, nemoci a nehod).

O tuto technologii mají zájem i filmová studia. Hlas anglicky mluvícího herce by mohl být použit v zahraničních kopiích bez nutnosti dabingu. Kanadská společnost Resemble AI již tvrdí, že dokáže převádět klonované anglické hlasy do 15 dalších jazyků.

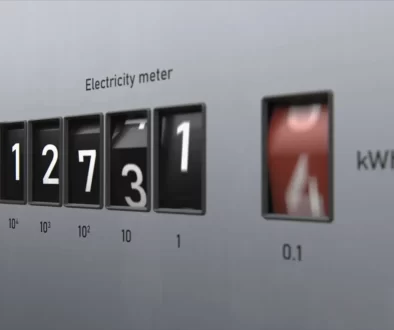

Klonování hlasu je však také potenciálně velkým rizikem. Systém lze použít k vytváření tzv. deepfakes. Odborník na kybernetickou bezpečnost Eddy Bobritsky, kterého cituje BBC, říká, že syntetické hlasy jsou nebezpečnou technologií, po které mohou podvodníci sáhnout, aby se vydávali za jiné lidi. O tom, že se nejedná o fiktivní hrozbu, svědčí známý příběh z roku 2019, kdy jeden britský manažer uslyšel hlas šéfa německé společnosti, kde pracoval, a na jeho žádost převedl ze svého firemního účtu 260 000 dolarů. Ukázalo se, že hlas byl falešný a že ho zfalšovali zločinci.